- تالیف: امید محمدیان پهلوان

- 1401-07-30 15:24:00

- کد مطلب : 4078

عملکرد سیستمهای هوش مصنوعی مبتنی بر تصمیمگیری است؛ سیستمهایی که از الگوریتمهای ماشین یادگیری و دادههای آموزشی تشکیل شدهاند. نتایج تصمیمگیری سیستمهای هوش مصنوعی ممکن است مثل پیشداوری ما انسانها در بسیاری از حوزهها، حامل سوگیریها و پیشداوریهایی باشند. یعنی خروجی الگوریتمُِ ماشینهای هوش مصنوعی بهخصوص در حوزههای اجتماعی، ساختارهای تبعیضآمیز نژادی یا جنسیتی و دیگر موارد را بازنمایی و چه بسا تقویت میکنند. انسانها به صورت ناخودآگاه پیشدارویهای تاثیرگذار بر قضاوتها را به فرآیند الگوریتم ماشینهای یادگیری سیستمهای هوش مصنوعی و یا دادههایآموزشی که ورودی الگوریتمهای مذکور هستند وارد میکنند. در این نوشتار ضمن تشریح مفهوم سوگیری در هوش مصنوعی، ابعاد خطرناک اجتماعی آن هم روشن میشود.

هوش مصنوعی؛ ارتقا عملکردها یا تقویت تبعیضها؟

هوش مصنوعی ابزار جدیدی در دست بشر است که حجم عظیم دادهها را با سرعت بیسابقهای پردازش میکند. اما این تنها ویژگی جذاب هوش مصنوعی نیست.

در اصل هوش مصنوعی، توانایی یادگیری دارد و البته به طور کلی سه توانایی اصلی برای هوش مصنوعی قائل میشوند: 1. درک 2. استدلال 3. یادگیری

هر سیستم هوش مصنوعی دو بخش اصلی هم دارد. یک؛ الگوریتمهای ماشین یادگیری و دیگری دادههای آموزشی[i] که در اصل ورودی این الگوریتمها برای پردازش میشوند.

اما هوش مصنوعی که برای تسهیل امور بشر پا به میدان گذاشته و روز به روز هم بر جذابیتَش افزوده میشود، با توجه به تواناییهایی شبیه به انسان همانند استدلال، درک و یادگیری و در نهایت امکان ارتقا این مهارتها، با خودش واهمههایی هم آورده است.

واهمههایی از جمله از دست رفتن بسیاری مشاغل که البته تا حدودی هم بیراه گفته نمیشود. چرا که پیشبینیها میگویند طی دهه جاری حدود 40 درصد مشاغل با سطح تحصیلات پایینتر به مدد انجام بسیاری از امور توسط هوش مصنوعی، دیگر در زندگی بشر تعریفی نخواهند داشت.

ترسهای عمیقتر از آیندههای دورتری هم وجود دارد، مثلا اینکه سیستمهای هوش مصنوعی از «سطح محدود» امروزی خود به سطوح «هوش مصنوعی عمومی» و یا «سوپر هوش مصنوعی» برسند و بر نوع بشر کاملا مسلط شوند. [ii](هوش مصنوعی (AI) چیست و چگونه کار می کند؟ + کاربردهای هوش مصنوعی, بدون تاريخ)

اما ما همین حالا هم با یک واقعیت تلخ دیگری مواجه هستم. اگر از این ترسهایِ دور و پیشبینیهایِ نزدیک فاصله بگیریم و کمی دقیقتر به اتفاقات خاص اخیر نظر کنیم متوجه میشویم که هوش مصنوعی در همین دورهِ سطح محدود و تکوظیفهای خود دردسرهایی آفریده است.

الگوریتمهای ماشین یادگیری برخی سیستمهای هوش مصنوعی در مواردی خروجیهایی تولید کردند که متاسفانه ساختارهای تبعیضی مبتنی بر نژاد و جنسیت موجود در جوامع را پررنگ و یا تقویت کردهاند.

به عنوان نمونه، در اوان همهگیری بود که ابزار هوش مصنوعی آنالیز تصاویر گوگل یا Cloud Vision گوگل، اشتباه نژاد پرستی از خودش نشان داد.

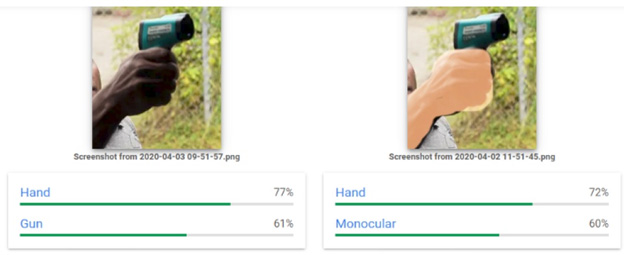

به این تصویر نگاه کنید:

هوش مصنوعی ابزار جدیدی در دست بشر است که حجم عظیم دادهها را با سرعت بیسابقهای پردازش میکند. اما این تنها ویژگی جذاب هوش مصنوعی نیست.

در اصل هوش مصنوعی، توانایی یادگیری دارد و البته به طور کلی سه توانایی اصلی برای هوش مصنوعی قائل میشوند: 1. درک 2. استدلال 3. یادگیری

هر سیستم هوش مصنوعی دو بخش اصلی هم دارد. یک؛ الگوریتمهای ماشین یادگیری و دیگری دادههای آموزشی[i] که در اصل ورودی این الگوریتمها برای پردازش میشوند.

اما هوش مصنوعی که برای تسهیل امور بشر پا به میدان گذاشته و روز به روز هم بر جذابیتَش افزوده میشود، با توجه به تواناییهایی شبیه به انسان همانند استدلال، درک و یادگیری و در نهایت امکان ارتقا این مهارتها، با خودش واهمههایی هم آورده است.

واهمههایی از جمله از دست رفتن بسیاری مشاغل که البته تا حدودی هم بیراه گفته نمیشود. چرا که پیشبینیها میگویند طی دهه جاری حدود 40 درصد مشاغل با سطح تحصیلات پایینتر به مدد انجام بسیاری از امور توسط هوش مصنوعی، دیگر در زندگی بشر تعریفی نخواهند داشت.

ترسهای عمیقتر از آیندههای دورتری هم وجود دارد، مثلا اینکه سیستمهای هوش مصنوعی از «سطح محدود» امروزی خود به سطوح «هوش مصنوعی عمومی» و یا «سوپر هوش مصنوعی» برسند و بر نوع بشر کاملا مسلط شوند. [ii]

اما ما همین حالا هم با یک واقعیت تلخ دیگری مواجه هستم. اگر از این ترسهایِ دور و پیشبینیهایِ نزدیک فاصله بگیریم و کمی دقیقتر به اتفاقات خاص اخیر نظر کنیم متوجه میشویم که هوش مصنوعی در همین دورهِ سطح محدود و تکوظیفهای خود دردسرهایی آفریده است.

الگوریتمهای ماشین یادگیری برخی سیستمهای هوش مصنوعی در مواردی خروجیهایی تولید کردند که متاسفانه ساختارهای تبعیضی مبتنی بر نژاد و جنسیت موجود در جوامع را پررنگ و یا تقویت کردهاند.

به عنوان نمونه، در اوان همهگیری بود که ابزار هوش مصنوعی آنالیز تصاویر گوگل یا Cloud Vision گوگل، اشتباه نژاد پرستی از خودش نشان داد.

به این تصویر نگاه کنید:

تصویر سمت چپ نشاندهنده تبسنج در دستان یک مرد رنگین پوست است که ابزار هوش مصنوعی آنالیز تصاویر گوگل، تب سنج را به عنوان یک اسلحه تشخیص میدهد

ولی در تصویر سمت راست که رزولوشن آن اصلاح شده و در ظاهر تبسنج به دست یک مرد سفید پوست افتاده، آنالیز تصاویر گوگل اشتباه نکرده و تشخیص درستی داشته است!

چرا باید یک ماشین مثل برخی از انسانها سوگیری نژادی داشته باشد؟

پاسخ ساده است، به این دلیل که داریم از یک ماشین هوشمندی صحبت میکنیم که انجام وظایف آن مبتنی برتوانایی استدلال و منطق فراگرفته از انسانها است. استدلال و منطقهای ساخته شده و در حال بازسازی که از طریق الگوریتم ماشین یادگیری و یادگیری عمیق و دادههای آموزشی، سوگیریهای خاص اجتماعی موجود در ذهن سازندگان خود (انسانها) را هم به ارث میبرند.

شاید بد نباشد که جمله استادِ شاهزاده کاسپین در پردههای اول فیلم 'سرگذشت نارنیا: شاهزاده کاسپین' را با نگاه جدید مرور کنیم. زمانی که استاد خطاب به شاهزاده سوار بر رخش خود و درحال فرار به سوی جنگل میگوید: «دیگر خیلی چیزهایی که یاد گرفتید در حال تغییر کردن است!» جملهای که امروزه هم انسان و هم ماشینهای هوش مصنوعی باید به آن به دقت فکر کنند.

سوگیری در سیستمهای هوش مصنوعی

در مثال آنالیز تصاویر گوگل، شاهد بودیم که خروجی یک سیستم هوش مصنوعی نتایجی مبتنی بر سوگیریهای نژادی که سابقا در جامعه موجود بوده را تکرار میکند. به این اتفاقات یا اشتباهات در خروجی سیستمهای هوش مصنوعی، 'سوگیری در سیستم هوش مصنوعی[iii]' میگویند. به عبارتی این سوگیری در هوش مصنوعی حاصل ناهنجاری در خروجی الگوریتمهای ماشین یادگیری است. این سوگیریها حاصل پیش داوریهای انسانی در فرآیند طراحی الگوریتمها یا مجموعه دادههای آموزشی است.

ابعاد خطرناک سوگیری در سیستمهای هوش مصنوعی

سوگیری در ذهن ما انسانها هم اتفاق میافتد، در اصل سوگیریهای شناختی حاصل فرآیند سادهسازی اطلاعات پیچیده محیطی در ذهن است که بر قضاوتهای ما تاثیرگذار است. اگر انسان به مرور ارزشها و جهانبینیاش تغییر کند و خودش کارگزار باشد ممکن است که در تصمیمات بعدی از سوگیریهای غلط قبلی خود فاصله بگیرد. اما در یک سیستم هوش مصنوعی این روند به شکل فوری اتفاق نمیافتد.

سیستمهای هوش مصنوعی در اصل با استفاده از دادههای که حاصل فرآیندها و ساختارهای تبعیضآمیز پیشین است، آموزش میبینند. این شرایط در مواردی که ما سیستمهای هوش مصنوعی را برای امور اجتماعی مثل سلامت و بهداشت یا امنیت عمومی به کار میبریم، در نهایت منجر به تکرار یا تقویت ساختارهای نابرابر و تبعیضآمیز نژادی، جنسیتی و سایر اقلیتها میشود.

در نمونهای، خروجیهای یک الگوریتم تخمین-ریسک نیازهای مراقبتی بیماران در آمریکا در نهایت سوگیریهای نژادی داشت. نتایج این ماشین هوشمند برای تعیین نیاز بیماران به مراقبت، به نفع بیماران سفید پوست تمام شده بود.

این الگوریتم برای حدود 200 میلیون شهروند آمریکایی به کار گرفته شد و به دلیل استفاده از دادههای تاریخی، چرخه معیوبی را در ساختار استدلال و تصمیم گیری به وجود آورده بود.

الگوریتم مورد نظر از متغیر «پرداختیها» برای تصمیمگیری استفاده کرده، در حالیکه دو متغیر درآمد و نژاد در آمریکا در خصوص تعیین نیازهای درمانی همبسته هستند و استفاده صرف یک متغیر از دو متغیر همبسته نتایج دقیقی را به ثمر نیاورد.

در موردی دیگر در یک سیستم هوش مصنوعی که برای هیأت قضات به منظور تخمین میزان تکرار جرم طراحی شده بود، سوگیریهای نژادی دیده شد. این سیستمِ ماشین هوش مصنوعی قرار بود با پیشبینی میزان احتمال تکرار جرم، به هیأت قضات در تعیین مدت حبس محکومین کمک کند. اما در نهایت ماشین هوش مصنوعی موارد بسیار کمتری در تخفیف دوره زمان محکومین سیاهپوستان در مقایسه با سفیدپوستان پیشنهاد داد.

دلیل این موضوع هم استفاده از مجموعه دادههای آموزشی تاریخی حاصل ادوار گذشته با ساختارهای تبعیضآمیز نژادی بوده که لزوما ثابت باقی نمانده و در حال تغییر بوده و هستند. چه بسا که بسیاری از محکومین سیاهپوست شایستگی لازم در تخفیف محکومیت به جهت تشویق شدن به عدم تکرار جرم را داشتند.

در مثال دیگری مدتی شاهد تبلیغات مشاغل خاص برای کاربران مختلف مبتنی بر سوگیریهای مذهبی، جنسیتی و نژادی در فیسبوک بودیم. به عنوان نمونه مشاغلی مثل رانندگی تاکسی برای آقایان و مثلا پرستاری برای کاربران خانم ظاهر میشد.

سوگیری شدیدا تبعیضآمیز دیگری در ماشین استخدام آمازون اتفاق افتاد. ماشین تصمیمگیری آمازون برای استخدام، به دلیل اینکه 60درصد کارکنان آمازون را مردان تشکیل میدادند، فرم درخواست مشاغلی که حامل اطلاعاتی دال بر جنسیت خانم متقاضی بود را در درجات پایینتر الویتبندی میکرد. این موارد هم نشاندهنده سوگیریهای مبتنی بر مسائل جنسیتی است.

در این نوشتار با مفهوم سوگیری در سیستمهای هوش مصنوعی آشنا شدیم و ابعاد خطرناک آن از لحاظ ساختارهای تبعیضآمیز نژادی و جنسیتی شرح داده شد. در آخر دوباره جمله استادِ شاهزاده کاسپین را یادآور میشوم؛ «چیزهایی که یاد میگیریم در حال تغییر کردن هستند». درنتیجه باید به یاد داشته باشیم که فراگیری سسیتمهای هوش مصنوعی باید همراه با لحاظ کردن تغییرات لازم در آن چیزیهایی باشد که تا به الان یادگرفتهایم و یا فکر میکنیم که یادگرفتهایم و آنها را ناخودآگاهانه به فرآیندهای منطق و استدلالِ الگوریتمهای ماشین یادگیری و دادههای آموزشی هوش مصنوعی وارد میکنیم.

منابع:

- Deligani, C. (n.d.). Bias 2022Bias in AI: What it is, Types, Examples & 6 Ways to Fix it in 2022. Retrieved from AI Multiple: https://research.aimultiple.com/ai-bias/

Thorn, J. (n.d.). Bias in Artificial Intelligence. Inequality, racism and discrimination. Retrieved from Towards Data Science: https://towardsdatascience.com/bias-in-artificial-intelligence-a3239ce316c9

- https://amerandish.com/EI4Xq

Thorn, J. (n.d.). Bias in Artificial Intelligence. Inequality, racism and discrimination. Retrieved from Towards Data Science: https://towardsdatascience.com/bias-in-artificial-intelligence-a3239ce316c9

- https://amerandish.com/EI4Xq

[i] Training data

[ii] بهطور کلی سیستمهای هوش مصنوعی از سه مرحله توانایی تشکیل شده است که شامل هوش مصنوعی محدود، هوش مصنوعی عمومی و سوپر هوش مصنوعی است. در مرحله اول یعنی هوش مصنوعی محدود که فعلا تنها با آنها سروکار داریم شامل سیستمهای هوشمندی است که یک وظیفه مشخص انسانی را با دقت و عملکرد بهتری اجرا میکنند. ما هنوز به هوش مصنوعیهای عمومی و سوپر هوش مصنوعی که در این مراحل خطر تسلط بر انسان وجود دارند، نرسیدیم و چشمانداز روشنی هم در دستیابی به این تواناییها وجود ندارد. در مرحله هوش مصنوعی عمومی، سیستم هوش مصنوعی همانند یک انسان میتواند محیط اطراف خود را درک کند و میتواند فراتر از یک وظیفه مشخص، وظایف انسانی را به شکل معمول و روزمره انجام دهد. مرحله سوپر هوش مصنوعی، مرحله فرضی است که احتمالا در آن هوش مصنوعی، هوش و درک انسانی را پشت سر بگذراد.

[iii] Bias In Artificial Intelligence

[iii] Bias In Artificial Intelligence