- امیر فرخاد

- 1402-01-27 07:19:00

- کد مطلب : 4123

از محققان دانشگاهی و صنعتی گرفته تا علاقمندان تازهکار، استودیوهای جلوههای بصری و تولیدکنندگان محتواهای مستهجن جملگی در ساخت دیپفیکها مشارکت دارند. دولتها نیز ممکن است به عنوان بخشی از استراتژیهای آنلاین و رسانهای خود، برای بیاعتبار کردن و متفرق کردن گروههای افراطی، یا برقراری تماس با افراد مورد نظر، از این فناوری کمک بگیرند.

دیپ فیک یا جعل عمیق چیست؟

آیا آن ویدیوی واکنشبرانگیزی که در آن باراک اوباما، دونالد ترامپ را یک «احمق» خطاب میکند تماشا کردهاید؟ نگاهمان میکند و از حرفهایش همه متعجب میشویم. یا درباره آن ویدیو که مارک زاکربرگ برای «کنترل کامل بر دادههای سرقت شده میلیاردها نفر» اظهار مباهات میکند، چگونه فکر میکنید؟ و یا شاهد عذرخواهی جان اسنوا برای پایان تلخ سریال بازی تاج و تخت کمی تسکیندهنده باشد! بله، ما این ویدیوها را تماشا کردهایم و باید بپذیریم از دیپفیکها متاثر شدهایم.

دیپفیکها همواره در حال بهروزرسانی و تلقین دهنده تجربههای نزدیک به واقعیت هستند. برای اینکه بدانید دیپفیک نسبت به گذشته تا چه اندازه پیشرفت کرده، به عکسهای قدیمیای رجوع کنید که هنوز بسیاری درباره واقعی یا جعلی بودن آنها تردید دارند. سرآمدترین نرمافزاری که به جعل و دستکاری عکسها شهرت یافت، فتوشاپ است. دیپفیک از نوعی هوش مصنوعی با عنوان یادگیری عمیق (Deep learning) برای ایجاد تصاویری از رویدادهای جعلی استفاده میکند؛ به همین علت هم با عنوان دیپفیک یا جعل عمقیافته شناخته و نامگذاری شده است. به این ترتیب، آیا میخواهید کلمات جدیدی را در دهان یک سیاستمدار قرار دهید، یا در فیلم مورد علاقه خود بازی کنید؟ یا به عنوان یک قهرمان المپیک با شما مصاحبه کنند؟ با دیپفیک همه اینها محقق میشود.

دیپ فیک با چه اهدافی ساخته میشود؟

از آنجایی که تکنیکهای جدید به افراد غیر ماهر امکان میدهد با تعداد انگشتشماری عکس، دیپفیک بسازند، ویدیوهای جعلی احتمالاً فراتر از دنیای افراد مشهور منتشر میشوند تا به پورن انتقامجویانه دامن بزنند. شرکت هوش مصنوعی Deeptrace در سپتامبر ۲۰۱۹، ۱۵۰۰۰ ویدیوی دیپ فیک را به صورت آنلاین پیدا کرد که تقریباً در طی ۹ ماه ۲ برابر شده بود. ۹۶ درصد از چهرههای مستهجن و ۹۹ درصد از چهرههای مشهور زن گرفته تا بازیگران معروف، فیلمهای پورن را ترسیم کردهاند. همانطور که دانیل سیترون، استاد حقوق در دانشگاه بوستون میگوید: «فناوری دیپ فیک تبدیل به سلاحی علیه زنان شده است.»

آیا دیپ فیکها فقط در قالب ویدیو تولید میشوند؟

الزاما خیر. دیپفیکها میتوانند در قالب عکسها و تصاویری که هرگز وجود خارجی نداشتهاند نیز ظاهر شوند. به طور مثال برای یک روزنامهنگاری با نام Maisy Kinsley که هرگز به دنیا نیامده [وجود خارجی نداشته] حسابی در شبکههای اجتماعی لینکدین و توییتر ایجاد شد که در آنها از یک چهره جعل شده استفاده کرده بودند و پروفایل این حسابها مدعی شده بود که او در رسانه بلومبرگ مشغول به کار است. نکته جالب این بود که برخی فعالان رسانهای هم این حسابها را دنبال کرده بودند.

صدا را نیز میتوان به صورت عمیق جعل کرد تا «پوستههای صوتی» یا «کلونهای صوتی» چهرههای عمومی ایجاد شود. اگر در یک ویدیو روی چهرهای که با صحبتهایش ما را شگفتزده میکند صدایی طراحی و هماهنگ نشود، احتمالا آن ویدیو ارزش تماشا ندارد. بنابراین صداهای تولید شده برای ویدیوهای دیپفیک میتوانند بطور مجزا منتشر شوند و یا بطور هدفمند و مستقل تولید شوند.

بطور مثال در مارس ۲۰۱۹، رئیس یک شرکت تابعه بریتانیایی یک شرکت انرژی آلمانی پس ازتماس تلفنی توسط یک کلاهبردار که صدای مدیرعامل آلمانی را با بهرهگیری از نرمافزارهای هوش مصنوعی تقلید میکرد، نزدیک به ۲۰۰ هزار پوند به حساب بانکی خودش در مجارستان واریز کرد. بیمهگران این شرکت معتقدند که این صدا یک فریب در قالب دیپفیک بوده است، اما شواهد آن مشخص نیست. طبق گزارشها، کلاهبرداریهای مشابهی از پیامهای صوتی ضبطشده واتساپ صورت گرفته است.

دیپ فیکها چگونه ساخته میشوند؟

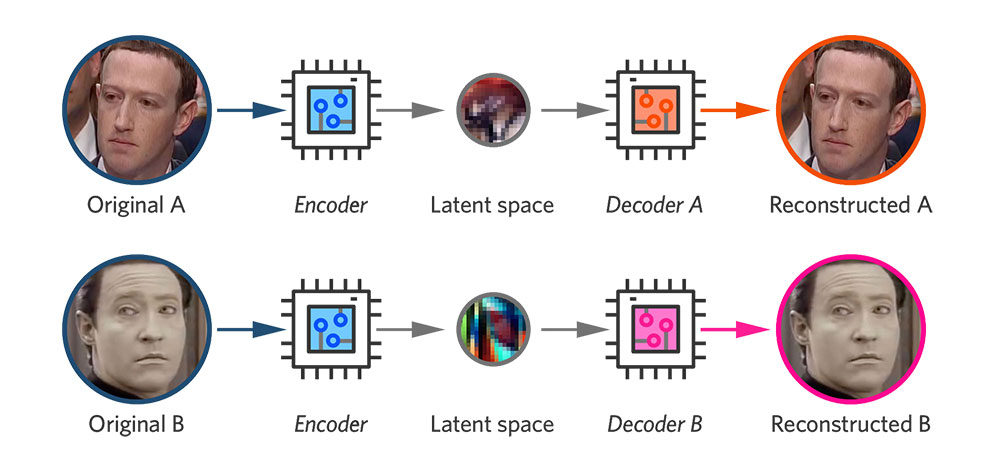

دیپ فیکها به معنای متعارف امروزی در سال ۲۰۱۷ متولد شدند، زمانی که یکی از کاربران ردیت، کلیپهای مستهجن را به همین نام در سایت منتشر کرد. در این ویدئوها چهره برخی افراد مشهور مانند گل گدوت، تیلور سوئیفت، اسکارلت جوهانسون با بازیگران فیلمهای پورن عوض شد. ساختن یک ویدیوی تغییر چهره یک فرآیند چند مرحلهای است. ابتدا، شما هزاران عکس از چهره دو نفر را از طریق یک الگوریتم هوش مصنوعی به نام رمزنگار (Encoder) پردازش میکنید. رمزنگار شباهتهای بین دو چهره را پیدا کرده و یاد میگیرد چگونه آنها را به ویژگیهای مشترک محدود و تصاویر را در این فرآیند فشرده کند. سپس دومین الگوریتم هوش مصنوعی به نام رمزگشا (Decoder) آموزش داده میشود تا چهرهها را از تصاویر فشرده بازیابی کند.

از آنجایی که چهرهها متفاوت هستند، یک رمزگشا را برای بازیابی چهره شخص اول و رمزگشای دیگری را برای بازیابی چهره شخص دوم آموزش میدهند. برای انجام تغییر چهره، به سادگی تصاویر کدگذاری شده را به رمزگشای «اشتباه» وارد میکنند. به عنوان مثال، یک تصویر فشرده از صورت شخص A به رمزگشای آموزش داده شده روی شخص B وارد میشود. سپس رمزگشا چهره شخص B را با عبارات و جهتگیری صورت A بازسازی میکند. برای یک ویدیوی متقاعدکننده و باورپذیر، این کار باید در هر فریم انجام شود.

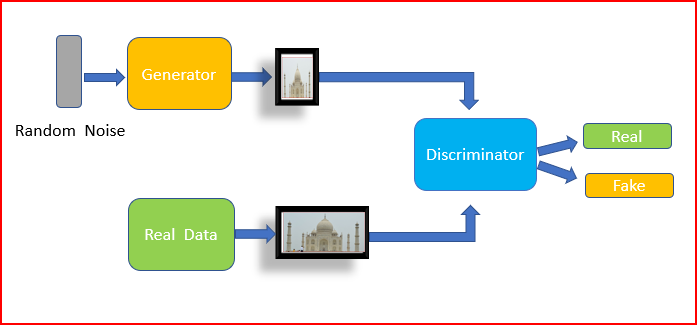

یکی دیگر از راههای ساخت دیپفیک استفاده از امکانی است که شبکه متخاصم مولد یا Gan نامیده میشود. یک گان دو الگوریتم هوش مصنوعی را در برابر یکدیگر قرار میدهد. الگوریتم اول که به نام مولد شناخته میشود، از نویز تصادفی تغذیه میکند و آن را تبدیل به یک تصویر میکند. سپس این تصویر مصنوعی به جریانی از تصاویر واقعی (مثلاً تصاویری از چهرههای افراد مشهور) اضافه میشود که به الگوریتم دوم، معروف به تمایزدهنده، وارد میشوند. در ابتدا، تصاویر مصنوعی هیچ شباهتی به چهرهها ندارند. اما این فرآیند بارها تکرار میشود تا با بازخورد عملکرد، تمایزدهنده و مولد هر دو بهبود یابند. هنگامی که چرخهها و بازخوردها به اندازه کافی رسیدند، مولد شروع به تولید چهرههای کاملا واقعی از افراد مشهور کاملاً ناموجود خواهد کرد.

از محققان دانشگاهی و صنعتی گرفته تا علاقمندان تازهکار، استودیوهای جلوههای بصری و تولیدکنندگان محتواهای مستهجن جملگی در ساخت دیپفیکها مشارکت دارند. دولتها نیز ممکن است به عنوان بخشی از استراتژیهای آنلاین و رسانهای خود، برای بیاعتبار کردن و متفرق کردن گروههای افراطی، یا برقراری تماس با افراد مورد نظر، از این فناوری کمک بگیرند.

برای ساختن دیپ فیک به چه فناوریای نیاز است؟

ساختن یک دیپ فیک خوب و تاثیرگذار در یک رایانه معمولی دشوار به نظر میرسد. بیشتر آنها روی رایانههای سطح بالا با کارتهای گرافیک قدرتمند و پیشرفته با قدرت محاسباتی سریع، در فضای ابری ایجاد میشوند. این امر زمان پردازش را از روزها و هفتهها به ساعتها کاهش میدهد. اما صرف استفاده از فناوری و ابزار کافی نیست؛ برای جلوگیری از لرزش تصاویر و سوسو زدنها باید به دانش و تخصص نیز تکیه کرد. هرچند که در حال حاضر ابزارهای کمکی بسیاری برای کاربران به منظور ساخت دیپفیک در دسترس است. چندین شرکت هستند که آنها را برای شما میسازند و تمام پردازشها را در فضای ابری انجام میدهند. حتی یک برنامه تلفن همراه به نامZaoوجود دارد که به کاربران امکان میدهد چهره خود را به فهرستی از شخصیتهای تلویزیونی و سینمایی که سیستم بر روی آنها آموزش دیده اضافه کنند.

تشخیص اینکه چه محتوایی یک دیپفیک است، با پیشرفت تکنولوژی دشوارتر میشود. در سال ۲۰۱۸، محققان آمریکایی متوجه شدند که چهرههای دیپ فیک به طور معمول پلک نمیزنند. البته نباید تعجب کنیم؛ اکثر تصاویر، افراد را با چشمان باز نشان میدهند. بنابراین الگوریتمها نمیتوانند درباره پلک زدن چیزی یاد بگیرند. نکته قابل پیشبینی این بود که به محض اینکه این تحقیق منتشر شد، دیپ فیکها با پلک زدن ظاهر شدند. ماهیت بازی چنین است، به محض اینکه یک نقطه ضعف آشکار شد، برطرف میشود.

دیپ فیکهای بیکیفیت راحتتر شناسایی میشوند. ممکن است همگامسازی لب با صدا بد باشد یا رنگ پوست در همه جای صورت یکسان نباشد. دیگر اینکه ممکن است در اطراف لبههای صورتهای جابجا شده پرش وجود داشته باشد. همچنین نمایش جزئیات ظریفی مانند مو، برای دیپ فیکها سخت است، به خصوص در جایی که تارهای مو در حاشیه تصویر ظاهر شده باشند. جواهرات و دندانهای «بد پردازش» نیز میتوانند شناسایی دیپفیک را تسهیل کنند. ضمنا تشخیص نورپردازیهای عجیب، مانند نور ناسازگار روی چهره و انعکاس آن روی عنبیه چشم هم میتواند واقعی به نظر رسیدن دیپفیکها را تهدید کند.

دولتها، دانشگاهها و شرکتهای فناوری همگی در حال تأمین بودجه تحقیقاتی برای شناسایی دیپفیک هستند. فیس بوک در ژانویه ۲۰۲۰ ویدیوهای دیپفیک را که احتمالاً بینندگان را گمراه میکرد تا فکر کنند کسی «حرفهایی گفته است که واقعاً نگفته» را در آستانه انتخابات ۲۰۲۰ آمریکا ممنوع کرد.

چگونه میتوان با دیپ فیک مقابله کرد؟

اگرچه دیپ فیک با بهرهگیری از هوش مصنوعی خلق میشود اما همین هوش مصنوعی است که در حال حاضر به شناسایی ویدیوهای جعلی کمک میکند، ولی بسیاری از سیستمهای تشخیص موجود یک ضعف جدی دارند: آنها فقط برای افراد مشهور خیلی خوب کار میکنند، زیرا میتوانند ساعتها با فیلمهای رایگانِ در دسترس اطلاعات مورد نیاز خود را کامل کنند. شرکتهای فناوری اکنون روی سیستمهای شناساییای کار میکنند که هدفشان این است که هر زمان که جعل و تقلبی ظاهر میشود آنجا را علامتگذاری کنند. استراتژی دیگر بر منشأ رسانه متمرکز است. بنابراین منشأ انتشار آنها همیشه قابل بررسی است.

آیا دیپ فیک همیشه مخرب است؟

خیر. بسیاری از آنها سرگرمکننده و حتی برخی مفید هستند. دیپفیکهای شبیه سازی صدا میتوانند هنگامی که افراد به دلیل بیماری صدای خود را از دست میدهند بازیابی کنند. همچنین میتوان از فناوری دیپ فیک برای بهبود دوبله فیلمهای خارجی استفاده کرد، و جالبتر اینکه بازیگران مرده را احیا و دوباره آنها را روی صحنه قرار داد.

منابع:

https://research.nvidia.com/publication/2018-04_progressive-growing-gans-improved-quality-stability-and-variation

https://theintercept.com/2015/06/22/controversial-gchq-unit-domestic-law-enforcement-propaganda/

https://apnews.com/article/ap-top-news-artificial-intelligence-social-platforms-think-tanks-politics-bc2f19097a4c4fffaa00de6770b8a60d

https://www.youtube.com/watch?v=cQ54GDm1eL0

https://www.theguardian.com/technology/2019/sep/02/chinese-face-swap-app-zao-triggers-privacy-fears-viral

https://arxiv.org/abs/1806.02877

https://ai.facebook.com/datasets/dfdc/

https://www.theguardian.com/technology/2020/jan/07/facebook-bans-deepfake-videos-in-run-up-to-us-election

https://www.youtube.com/watch?v=Ox6L47Da0RY

https://www.youtube.com/watch?v=4GdWD0yxvqw